12 Avril 2013

Vous avez aimé les réacteurs nucléaires et admiré leurs prestations notamment à Tchernobyl et Fukushima, et à ces occasions vous avez pu apprécier le sérieux apporté à la conception et à l’exploitation de ces magnifiques réalisations.

Vous serez alors comblés par le spectacle que nous promet la prochaine version conçue par le Docteur Folamour, il s’agit du réacteur Flexblue.

Rappelons d’abord que, malgré les mouvements d’opinion exigeant la sortie du nucléaire, les objectifs de développement de la filière sont confortés et donc que les travaux continuent pendant la crise.

En France, ITER, ASTRID, EPR, se portent bien , merci.

Le fournisseur avisé d’électricité doit avoir un catalogue complet pour être en mesure de s’imposer sur le marché mondial.

Pour les pays développés, qui disposent d’une infrastructure de distribution électrique très complète, la solution choisie ( à tort ou à raison) est celle des grosses centrales équipées de réacteurs de 1 500 MWe du type de l’EPR.

Cette solution ne convient pas pour équiper des pays dépourvus d’infrastructure électrique. Il faut alors proposer des petites unités ( 50 à 250 MWe) pour alimenter des réseaux locaux.

Ce projet de dissémination de petites unités nucléaires dans des zones à stabilité politique précaire et souvent en proie à des conflits locaux, a bien sûr soulevé le problème de la sécurité. La vulnérabilité des petites installations terrestres à des attaques terroristes est un obstacle à leur implantation, et peut-être contraire à l’esprit de lutte contre la dissémination de la technologie nucléaire..

Pour tourner la difficulté, le Docteur Folamour a proposé tout simplement d’installer ces réacteurs au fond de la mer !

C’est le projet Flexblue de la DCNS.

Il s’agit en gros de placer le réacteur dans une sorte de sous-marin sans équipage, et de déposer la chose sur des fonds de 50 à 100 mètres de profondeur, à peu de distance de la côte à alimenter.

L’étude est quasiment terminée. Il reste maintenant à évaluer la validité du concept par rapport aux risques de sécurité.

Pour cette phase, essentielle dans le contexte actuel, on aurait pu penser que l’industriel aurait fait appel à ses meilleurs ingénieurs. En fait c’est un stagiaire qui est recruté !

On trouvera ci-après un extrait de l’annonce pour le recrutement de la personne qui travaillera sur le problème:

« Stage Performances de sûreté d'un réacteur immergé à sûreté passive (Flexblue) (1 poste)

Employeur : DCNS

…L’architecture préliminaire des systèmes ayant été définie, il s’agit désormais de valider et de quantifier les performances de ces systèmes, afin de s’assurer du respect des exigences de sureté.

Le/la stagiaire simulera des scénarios accidentels du réacteur Flexblue en s'appuyant sur des codes thermo hydrauliques de type CATHARE (et neutroniques si besoin). Les scénarios d'intérêt seront à déterminer en début de stage : par exemple accidents de perte de réfrigérant primaire (APRP), rupture de tuyauterie vapeur (RTV) et station blackout.

Le stagiaire évaluera les performances de sûreté de Flexblue dans ces scénarios, notamment à travers diverses études de sensibilité sur certains paramètres physiques et émettra des recommandations aux concepteurs du réacteur. On comparera ces performances avec celles des réacteurs terrestres.

Le/la stagiaire travaillera avec l'équipe conception du réacteur Flexblue, les équipes de dimensionnement et de fabrication des composants nucléaires DCNS et les spécialistes de codes de calcul….. » .

Bien sûr, on n’imagine pas que le stagiaire sera laissé seul en face d’un problème aussi primordial, mais on aurait quand même préféré un ingénieur sénior confirmé, et mieux encore une équipe pluridisciplinaire.

Quant à évaluer la sureté d’une telle installation sous-marine par rapport aux risques de sabotages terroristes, le Docteur Folamour ignore probablement qu’il est plus facile d’aller poser une mine magnétique sur une cible fixe aux profondeurs envisagées que de s’attaquer en terrain découvert à une installation terrestre qui peut être bunkerisée et gardée.

D’autre part, en l’absence de personnel permanent dans la centrale sous-marine, toute intervention de première urgence est impossible et c’est l’accident de niveau 7 assuré, avec les conséquences sur l’environnement que l’on peut aisément imaginer.

Décidément les leçons de Fukushima n’ont pas été comprises, le déni du risque reste ancré dans les esprits.

Il nous reste à espérer que les réductions budgétaires viendront à bout de ce projet démentiel.

Et de quelques autres du même tonneau.

8 Avril 2013

Le 1er Avril est désormais suffisamment loin pour pouvoir enfin parler de choses sérieuses avec quelque crédibilité.

On sait que, dès ses origines, la religion du pétrole s’est trouvée scindée en deux courants de pensée fondés sur des genèses différentes.

L’un, devenu très largement majoritaire, fonde la genèse du pétrole sur le processus d’enfouissement et de décomposition lente de matières organiques, sur des durées géologiques qui se mesurent en millions d’années. Ce processus conduit à un « stock » par définition limité, et donc fait du pétrole un produit dont les réserves sont finies.

L’autre, minoritaire pour ne pas dire confidentiel, et considéré comme hérétique, soutient une genèse différente et complémentaire faisant appel à un processus métamorphique naissant à grande profondeur dans le manteau terrestre, par réaction entre éléments exclusivement minéraux. Ce processus serait continu et donc conduirait à des stocks de produit illimités.

Les adeptes de la seconde théorie sont une poignée de chercheurs plus ou moins indépendants, largement discrédités par le courant majoritaire. Ils s’appuient sur les travaux de recherche géologique poursuivis dans le monde entier dans des buts d’approfondissement des connaissances de l’évolution de la croute terrestre et de la diagénèse. Ces travaux explorent notamment le comportement de la matière dans les conditions de haute pression et de haute température qui règnent dans les profondeurs de la terre. Ils ont conduit entre autres à des résultats encourageants concernant la possible formation d’hydrocarbures à partir de roches carbonatées, et donc donné quelque crédit à la théorie hérétique.

La validité d’une théorie s’appuie sur sa capacité à expliquer les phénomènes de son domaine d’application, et à prévoir des phénomènes nouveaux vérifiés ensuite par l’expérimentation.

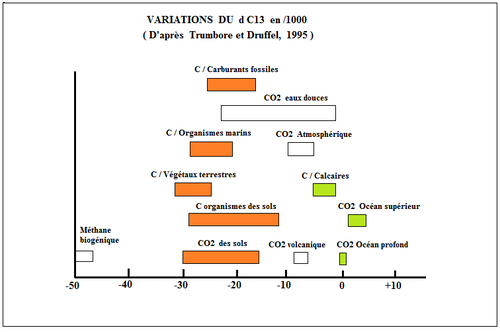

En l’occurrence, pour prouver l’existence du pétrole abiotique, il faut se donner les moyens scientifiques et technologiques de l’identifier par rapport au pétrole biotique.

Ces moyens existent.

Le pétrole « conventionnel » (biotique) contient de nombreux composants, que l’on peut regrouper en quatre familles:

- Les composants de base, construits à partir des corps simples Carbone, Hydrogène, Soufre, Oxygène, Azote.

Ces composants de base sont en proportions variées qui dépendent du kérogène initial et des conditions de transformation de ce kérogène en pétrole. Le kérogène dépendant lui-même de la matière organique origine et de ses conditions d’évolution:

Résines, Asphaltènes, Hydrocarbures aromatiques et paraffiniques, etc...

Ainsi chaque pétrole possède sa propre histoire, différente des autres pétroles issus de couches sédimentaires différentes.

Il est possible, par l’analyse des composants de base, de déterminer l’origine d’un échantillon.

- Des composants reflétant la radioactivité du milieu dans lequel s’est formé le pétrole.

- Des composants minéraux autres que C, H, O, S et N, issus de la matière organique initiale.

- Des fossiles moléculaires, véritables archéosquelettes des molécules organiques présentes à l’origine de la formation des kérogènes.

Lorsque les molécules organiques se dégradent, certaines chaînes moléculaires se conservent et se retrouvent dans le kérogène et ensuite dans le pétrole, constituant une signature de l’origine du produit.

(Le lecteur curieux ou sceptique pourra consulter la thèse de Sylvain Bernard,

« Préservation de fossiles organiques au cours de la diagénèse et du métamorphisme »

Soutenue en 2008 à l’Université Denis Diderot, paris VII.

Ou celle de Bertrand Chappe,

« Fossiles moléculaires d’archéobactéries », de 1982 ).

Ces fossiles moléculaires, qui peuvent être présents dans le pétrole biotique (mais pas nécessairement), sont en principe absents des pétroles abiotiques.

Il « suffit » donc de réaliser une analyse fine d’un échantillon de brut pour déterminer sa provenance et donc pour identifier un éventuel intrus abiotique.

La polémique médiatique autour de l’origine possiblement abiotique d’une partie du pétrole peut donc s’appuyer sur des outils scientifiques permettant d’atteindre en quelque sorte l’ADN du produit et donc son origine sans ambigüité.

A condition bien sûr qu’il n’y ait pas eu de mélange entre les deux produits…

5 Avril 2013

En France, la crédibilité d’une information est inversement proportionnelle à la proximité de sa date de parution par rapport au 1er Avril, ce qui entraine parfois à l’inverse une crédulité d’autant plus grande que l’on s’éloigne de la date fatidique.

Les informations qui vont suivre seront donc reçues avec le degré de considération qui convient à un 5 Avril.

Nous avons rappelé dans l’article précédent que les expériences de laboratoire confirment la possibilité d’obtenir du Méthane et d’autres hydrocarbures abiotiques plus complexes à partir de composés minéraux donneurs de Carbone et d’Hydrogène, et dans des conditions de température et de pression élevées .

Ces synthèses sont réalisées grâce entre autres au dispositif de cellule à enclume de diamant.

De telles conditions existant dans la partie supérieure du manteau terrestre, il n’est pas interdit de penser que des hydrocarbures ont pu s’y former à partir de composés minéraux présents comme CaCO3 et H2O contenus dans la roche.

L’horizon considéré se situe de 100 à 200 km de profondeur, donc au-delà des possibilités de vérification in situ, tout au moins aujourd’hui.

Il est évidemment tentant de supposer que si ces hydrocarbures abiotiques se forment effectivement à grande profondeur, une partie d’entre eux au moins peut migrer vers la surface et se retrouver à l’état de Méthane ou de pétrole mélangé ou non aux hydrocarbures d’origine biologique.

Le problème est donc maintenant d’étudier le devenir de ces produits des grands fonds afin de comprendre les éventuelles transformations subies et les possibilités de migration à travers les failles de la croute terrestre.

De nombreux laboratoires de géophysique travaillent sur le sujet dont l’intérêt n’aura échappé à personne, au-delà du simple progrès des connaissances en géophysique.

Nous voulons présenter ici un article publié par les

« Proceedings of the National Academy of Sciences of United States of America » , Volume 108 No 17, de Leonardo Spanu, paru le 11 Avril 2011. ( Eh oui encore le mois d’Avril).

Article relayé par le «Lawrence Livermore National Laboratory ».

Ces deux honorables institutions ne sont pas des repaires de plaisantins, faut-il le souligner.

Voici un extrait traduit du sommaire:

« La détermination des propriétés thermochimiques des Hydrocarbures à haute pression et température est une étape clé dans la compréhension des réservoirs de Carbone et des flux dans les profondeurs terrestres.

La stabilité des systèmes Carbone-Hydrogène à des profondeurs supérieures à quelques milliers de mètres est mal comprise et l’extension des hydrocarbures abiotiques dans le manteau supérieur terrestre demeure un sujet de controverse……Nos résultats montrent que les hydrocarbures complexes deviennent plus stables entre 1000 et 2000 K et pour des pressions supérieures à 4 Giga Pascal….

Nos résultats fournissent une interprétation unifiée de plusieurs expériences récentes et un modèle microscopique détaillé de la dissociation du Méthane et de sa polymérisation à haute pression et température ».

Ces travaux sont soutenus par la Fondation SHELL pour la recherche.

Cet illustre parrainage n’est évidemment pas un hasard, la compagnie en question n’ayant pas pour habitude de s’intéresser à des projets cosmétiques.

Il faut cependant insister sur le fait que ces travaux et ces quelques résultats intéressants n’autorisent en aucune façon à conclure à propos d’une possible résurgence d’hydrocarbures abiotiques à portée de forages de types conventionnels (quelques km de profondeur).

Ils n’autorisent pas non plus à conclure à leur impossibilité.

La controverse actuelle est utile pour nourrir le débat et suggérer des pistes de recherche et d’expérimentation. Toute tentative d’imposer par avance une conclusion serait une imposture intellectuelle.

1er Avril 2013

Il n’était pas possible de laisser passer le 1er Avril sans évoquer un sujet plus distrayant que les arcanes de la transition énergétique.

Quoique, comme nous le verrons ensuite, ce sujet nous y ramène malgré nous, mais n’anticipons pas.

Tout le monde ( enfin presque) a gardé en tête l’affaire du Coelacanthe, qui un temps a partagé la communauté scientifique entre croyants et incroyants, les premiers subissant les quolibets des seconds, autoproclamés détenteurs de la vérité.

Jusqu’au jour où un scientifique s’est avisé de quitter son laboratoire pour aller un peu sur le port interroger les pêcheurs. Il découvrit alors que le poisson mythique que l’on croyait disparu depuis des millions d’années, est en fait une espèce bien vivante comme vous et moi, commune dans son biotope.

Le sujet dont je voudrais vous entretenir aujourd’hui s’apparente à l’affaire du poisson qui s’obstine à exister malgré les condamnations des savants docteurs.

Il s’agit du pétrole abiotique.

La polémique est connue, peut-être pourrait-on en rappeler brièvement les éléments:

La théorie officielle de la formation du pétrole, élevée à la hauteur d’un dogme, attribue l’origine de ces hydrocarbures à la décomposition de matières organiques enfouies dans des couches sédimentaires il y a des millions d’années.

En face de cette théorie bétonnée il existe, depuis fort longtemps, une autre théorie selon laquelle le pétrole serait dû, au moins en partie, à des phénomènes métamorphiques affectant les roches à très grande profondeur, donc très fortes pressions et températures. Les hydrocarbures ainsi formés remonteraient ensuite vers la surface par des failles affectant la croute terrestre.

On comprend aisément l’enjeu. Si cette théorie schismatique rencontrait une confirmation, alors il n’y aurait plus de limite à la production du pétrole, avec les conséquences que l’on imagine aisément.

Comme toute théorie, celle-ci ne peut recevoir de considération que si elle subit l’épreuve de la vérification expérimentale.

Et, en premier lieu, il est donc nécessaire d’établir la validité des principes de base qui la fondent.

Ces principes s’énoncent clairement: Dans des conditions de très fortes pressions et très hautes températures, et avec l’intervention de catalyseurs appropriés, il est possible d’obtenir des hydrocarbures à partir de composés minéraux donneurs potentiels de Carbone et d’Hydrogène.

Le Carbone pouvant être issu de Carbonates, et l’Hydrogène fourni par l’eau contenue dans la roche.

Ceci doit être démontré avant de commencer à prendre la théorie en considération.

L’expérimentation n’est pas à la portée du premier bricoleur venu. Les phénomènes en question sont censés se produire à des températures de 600 à 1 500 °C et des pressions de 20 à 70 KBar ( La pression atmosphérique est de 1 Bar).

Heureusement les scientifiques sont pleins de ressources. L’études des réactions dans les conditions de hautes pressions et de hautes températures intéresse de nombreux domaines de la Science et de la Technologie (Recherche fondamentale, métallurgie, pétrologie, comportement des poudres, étude des origines de la vie, géomorphologie, étude des états extrêmes de la matière, etc…).

Un dispositif permettant ce genre d’études a été mis au point dès 1958 au NBS ( Aujourd’hui National Institute of Standards and Technology) aux Etats-Unis.

Il s’agit du DAC ( Diamond Anvil Chamber, ou Cellule à enclume de diamant) couramment utilisé aujourd’hui pour le genre d’études citées.

L’appareil permet d’atteindre des pressions jusqu’à 360 GPa et des températures jusqu’à 4700 °C.

360 GigaPascal représentent 3,6 millions de fois la pression atmosphérique !

Le principe en est simple:

L’échantillon à torturer est placé entre deux diamants convenablement taillés en pointes, le tout serré dans un étau. La complexité réside dans la réalisation pratique. L’avantage des enclumes en diamant tient à la transparence du matériau qui permet des mesures optiques ( diffraction des RX, spectroscopie). L’inconvénient est évidemment la petite taille des échantillons.

On trouvera une bonne description d’un DAC sur le site de l’Université d’Oxford, Département des Sciences de la Terre, pétrologie expérimentale.

Selon les spécialistes ( les officiels, pas les hérétiques) des hydrocarbures abiotiques ne pourraient se former que dans l’Asthénosphère, à des profondeurs de l’ordre de 200 km, où l’on trouve les conditions requises par la théorie (l’officielle), 600 à 1500 °C et 20 à 70 Kbar.

Comme il n’est pas question d’aller creuser aussi loin, la seule façon d’expérimenter, c’est la cellule à enclume de diamant.

Divers essais ont été réalisés à partir des composants de base CaCO3, H2O et Fe3O4, qui on permis d’obtenir des composés CnHn+2, ou directement CH4.

Les expériences ont été menées avec la cellule à enclume de diamant, et (par d’autres labos) avec la chambre à haute pression CONAC qui permet de travailler sur des échantillons plus importants.

L’analyse des produits de réaction a été réalisée par spectroscopie Raman, chromatographie en phase gazeuse, etc...

Ces résultats apportent la preuve que des hydrocarbures peuvent se former dans le manteau terrestre à partir de composés minéraux présents en abondance dans le milieu.

Reste maintenant à expliquer la migration de cette substance jusqu’au niveau de la croute terrestre.

Mais ce premier résultat acquis justifie un approfondissement du sujet, qui ne peut plus être remisé dans le placard à hoaxes.

Le lecteur, que cette parution un 1er Avril n’aura pas rebuté, n’aura aucun mal à trouver de nombreuses sources d’informations (ou de déformation) sur la toile.

30 Mars 2013

La nécessité d’une transition énergétique n’est plus à démontrer.

Même le citoyen le moins informé ne peut plus ignorer que nous allons devoir accomplir trois révolutions à la fois industrielle, économique et sociale:

- Réduire drastiquement notre consommation d’énergie.

- Se passer des sources d’énergie fossiles.

- Développer la production et l’usage des énergies propres et renouvelables.

A ce programme déjà très ambitieux il faut ajouter une option qui est l’abandon du Nucléaire civil.

Les solutions technologiques disponibles pour tenter de réaliser cette transition sont déjà connues, et pour certaines déjà utilisées à petite ou moyenne échelle. Rappelons-en les grandes composantes:

- Hydraulique.

- Biomasse.

- Biocarburants.

- Solaire.

- Eolien.

- Géothermie.

- PAC.

Il n’est donc pas nécessaire d’entreprendre des recherches fondamentales pour découvrir des principes nouveaux.

Par contre des travaux de développement de filières industrielles restent indispensables pour optimiser les rendements et atteindre la compétitivité.

Les obstacles à la transition énergétique ne sont donc ni théoriques, ni technologiques.

Les problèmes sont politiques, économiques et financiers.

Ce sont hélas les plus difficiles à résoudre.

Dans la liste des sources d’énergie nouvelles disponibles, nous n’aurons pas à effectuer un choix, il faudra les mettre toutes en œuvre.

Et cela va coûter très cher, on parle de milliards pour la prochaine décennie.

Le problème de la transition énergétique se résume donc à la recherche d’un trésor dans lequel il serait possible de puiser à hauteur d’au moins mille milliards à court/moyen terme, disons d’ici 2020-2025.

Sans cet effort financier la transition restera un vœux pieu et sera reportée à des jours meilleurs.

Il n’est un secret pour personne que l’Etat ne possède pas ce trésor, mais qu’il doit au contraire des sommes colossales à des créanciers majoritairement étrangers.

On ne peut imaginer se procurer cet argent par un accroissement de la dette nationale, autant saborder le navire tout de suite.

De toutes façons, en économie de marché, ce n’est pas à l’Etat de se substituer aux investisseurs, son rôle est de définir des orientations, de soutenir des budgets de recherche et de développement de filières industrielles, et d’aider à la création de savoir-faire.

Les Zinzins prennent ensuite le relais pour la phase industrielle, à condition qu’il existe des perspectives de rentabilité.

Et c’est là que la bât blesse.

Dans les énergies renouvelables les perspectives de retour sur investissements ne sont pas évidentes.

En effet, le Solaire et l’Eolien, puisque c’est d’eux qu’il s’agit essentiellement, produisent de l’électricité à un coût très supérieur au prix de vente fixé par le tarif public. Ceci est logique puisqu’il s’agit de technologies en phase de maturité, donc en début de courbe d’apprentissage, rien d’anormal en cela. Il faudra dix à quinze ans pour que, grâce à l’économie d’échelle qui permet l’optimisation des coûts, la production soit compétitive en face des procédés actuels largement amortis.

Le développement de ce nouveau secteur implique donc la mise en place d’un modèle économique qui permet d’accepter les coût élevés des ENR tout en conservant un tarif public de l’énergie acceptable par les consommateurs, et ceci pour une durée de dix à quinze ans.

Ce modèle est basé sur d’une part un tarif d’achat de la production des ENR compatible avec la rentabilité des installations, et d’autre part sur le financement du surcoût par le consommateur à travers la taxe spéciale CSPE, aidée éventuellement de la TICPE appliquée aux énergies de réseaux.

Au terme d’une période « d’apprentissage » , qui peut durer une dizaine d’années voire davantage, les coûts de production Eolien et Solaire se réduiront, en même temps que le prix public de l’énergie augmentera. Les deux se rencontreront autour d’un prix qui sera deux à trois fois le prix actuel.

Il s’agit d’une adaptation progressive de l’Industrie à de nouvelles structures de production, et des usagers à un nouvel environnement où le coût de l’énergie ne sera plus compatible avec le laxisme actuel en matière de consommation.

Cette transition ne pourra s’effectuer que sur le long terme, et à un rythme qui dépendra de la situation économique du pays.

Les consommateurs ne seront pas au bout de leur peine.

En même temps qu’ils financeront le développement des ENR, ils devront financer le démantèlement des vieilles centrales nucléaires, qu’il faudra bien arrêter un jour, la construction des nouvelles centrales ( soit EPR, soit à gaz et Co-génération), et investir dans l’isolation thermique de leurs logements.

Toutes ces dépenses, inévitables sous peine de rater la transition énergétique, donnent le vertige. Un tel challenge paraît tout simplement fantaisiste dans le contexte économique actuel exposé par les média comme un cumul de situations catastrophiques.

Et pourtant l’argent est là.

Selon le BIPE, les français épargnent chaque année 16% de leurs revenus. Leur patrimoine cumulé s’élèverait à 11 000 Milliards d’euros, et leur épargne financière à 5 000 Milliards !

Ces chiffres, qui ressemblent à une provocation, sont hélas la réalité.

Bien sûr ce pactole ne concerne ni les chômeurs, ni les travailleurs précaires, ni les petits retraités.

On notera au passage qu’une partie de la dette nationale est contenue dans ce prodigieux bas de laine ( le reste de la dette est détenu par des étrangers).

Il y a donc des français riches.

Le problème du financement de la transition énergétique et, au passage, du remboursement de la dette nationale, se résume donc à trouver un moyen d’exercer une ponction sur le tas d’or détenu par les nationaux.

O bien sûr, il ne s’agit pas d’utiliser la méthode chypriote, peu dans les traditions de chez nous ( quoi que ), mais d’exercer une certaine pression pour orienter les placements vers par exemple la nouvelle banque d’investissement, et/ou d’inventer quelque taxe subtile qui aboutirait au même résultat sans toutefois provoquer la fuite des capitaux.

A vot’ bon cœur m’sieu dames…

26 Mars 2013

Le débat National sur la transition énergétique est donc lancé.

Tout le monde peut y participer, tout au moins donner son avis, étant entendu qu’aucun référendum n’est prévu pour ratifier une éventuelle décision populaire.

Un site internet servira de « dazibao » , avec la même efficacité démocratique que jadis chez nos amis de l’Empire du milieu.

En quelque sorte un défouloir cathartique se revendiquant de la démarche démocratique, sans préciser que la démocratie dont on parle n’est pas le gouvernement par le peuple, mais l’art de gouverner le peuple, ce qui n’est pas tout à fait la même chose, on en conviendra.

Pour l’édification des foules, la ministre concernée ( Madame Delphine Batho) a diffusé un document explicatif baptisé « socle de connaissances », fort bien fait au demeurant, sorte de Vade-mecum du petit énergéticien.

Tout un chacun peut y trouver de quoi alimenter moult polémiques, sur des bases un peu moins fantaisistes qu’au café du commerce.

A condition toutefois d’en entreprendre la lecture ( 92 pages), ce qui requiert une certaine abnégation, la chose étant nettement moins divertissante que la lecture d’un journal sportif ou du dernier Amélie Nothomb ( Quoique, diront les mauvaises langues).

Mais nous devons saluer l’effort de communication, une fois n’est pas coutume.

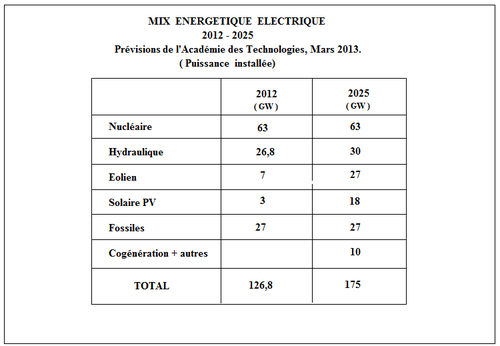

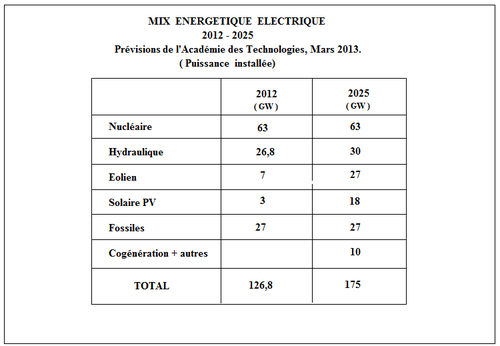

Comme nous l’avons déjà montré dans un article précédent, aucune stratégie de transition énergétique française ne peut être élaborée sérieusement sans avoir préalablement décidé de l’avenir du Nucléaire civil.

A ce sujet, le « socle de connaissances » que l’on est prié d’assimiler contient une tirade ( p 21) qu’il convient d’exposer in extenso:

« Par ailleurs, la France est particulièrement concernée par la nécessité de maîtriser les risques associés à la filière nucléaire. A ce titre, l’Autorité de Sureté Nucléaire ( ASN) a imposé, dans le cadre des « stress tests » engagés au niveau européen suite à la catastrophe de Fukushima, des évaluations complémentaires de sureté des installations nucléaires françaises. A l’issue de ces évaluations, l’ASN considère que les installations examinées présentent un niveau de sureté suffisant pour n’en arrêter aucune, mais que la poursuite de leur exploitation exige un renforcement de leur niveau de sureté, décliné depuis à travers de nombreuses prescriptions » .

Le ton est donné, le Nucléaire n’est pas à priori écarté du futur bouquet énergétique .

La seule porte de sortie serait alors un blocage des travaux d’amélioration de la sureté, décision qui entraînerait automatiquement l’arrêt d’un certain nombre de réacteurs.

Mais une telle décision n’est pas dans les attributions de la Commission du débat National sur la transition énergétique.

Pour ceux qui n’auraient pas très bien saisi, un autre paragraphe ( p33) rappelle les engagements de M. François Hollande:

- Fermer la centrale nucléaire de Fessenheim fin 2016.

- Achever le réacteur EPR de Flamanville.

Pour Fessenheim, rappelons qu’il s’agit de la plus ancienne centrale Nucléaire française, en exploitation depuis 1978, un quasi prototype REP arrivé en fin de vie ( 38 ans en 2016) et dont l’espérance de vie était estimée à quarante années. Passer outre et prolonger la durée d’exploitation au-delà de quarante ans représenterait une prise de risque importante à cause de la fragilisation de l’acier de la cuve, liée à un dépassement de la limite de sureté du flux neutronique cumulé acceptable.

L’arrêt de cette centrale est donc une décision technique plus que politique.

Achever le réacteur EPR de Flamanville est un engagement d’une tout autre importance, qui implique la volonté de mener à son terme le développement industriel de la filière.

Et dans quel but, sinon d’en faire la promotion urbi et orbi ?

Or la commercialisation au plan mondial d’une filière nucléaire doit s’appuyer nécessairement sur un savoir faire global maîtrisant tous les maillons de la chaîne, et ceci n’est possible que s’il existe un marché intérieur.

Le marché en question est celui du remplacement des réacteurs de première génération qui arriveront en fin de vie au cours de la prochaine décennie.

Seul un gros grain de sable pourrait bloquer la mécanique nucléaire déjà lancée.

Et ce grain de sable pourrait bien venir du Japon, qui est en train de reconsidérer sa stratégie nucléaire en regard des problèmes énergétiques rencontrés après la mise à l’arrêt du parc.

Au fait, et la Politique Européenne ?

Bon sang, mais c’est bien sûr, il n’y a pas de Politique Européenne…

Ref:

19 Mars 2013

Dans notre société dite « occidentale » la technologie occupe une place envahissante, devenue pour une majorité d’entre nous l’indispensable truchement entre nos désirs illimités et leur réalisation.

L’Homme moderne est désormais captif d’un monde de dispositifs qui sont autant de prothèses: Appareils électroménagers, automatismes divers, automobile, téléphone portable, Smartphone, Multimédia, Internet, ordinateur, tablettes, GPS, Cartes de crédit, clés USB, reconnaissance vocale, passeport biométrique, Domotique, télécommandes diverses, dispositifs RFID, etc, qui transforme l’individu en une mouche prisonnière d’une toile d’araignée numérique dont on ne sait pas très bien qui est l’araignée et quelles sont ses intentions.

Le fonctionnement de toute cette technologie n’est possible que grâce à un apport fabuleux d’énergie, faute de quoi le système s’arrêterait en quelques heures.

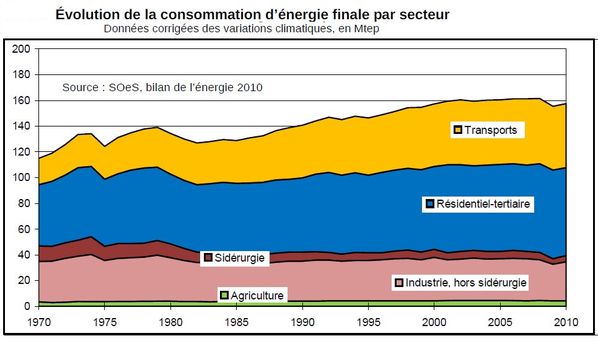

Notre ruche est subdivisée économiquement en trois secteurs: Le Résidentiel, le Tertiaire, et l’Industriel.

Le secteur résidentiel regroupe les activités relatives à la vie privée des individus.

Les deux autres secteurs ont pour vocation de fabriquer les produits et les services destinés au résidentiel.

Etant par définition un potentiel d’action, l’énergie est nécessaire chaque fois qu’une action est requise.

C’est ainsi que, bon an mal an, nous consommons 2 000 TWh pour faire tourner le moteur de la maison France. On parle alors d’énergie « primaire ».

Les individus, dans leur secteur résidentiel, en consomment environ 40%, pour leurs besoins domestiques et de transports particuliers.

Le reste est utilisé par les secteurs tertiaire et industriel pour leur procurer tout ce dont ils ont besoin dans le cadre de la société moderne: Logement, équipements domestiques, équipements de loisirs et de culture, alimentation, moyens de transport particuliers, réseaux de distribution d’énergie, infrastructures territoriales, transports collectifs, équipements de santé publique, d’enseignement, de sureté nationale, services publics, etc, etc…

Une partie des individus, appelés actifs, ont en charge la mise en œuvre de ces deux secteurs. Ils représentent environ 40% de la population.

Une fois terminée leur journée de travail, ils regagnent le secteur résidentiel.

L’usager est familiarisé avec l’énergie qu’il consomme dans le cadre de son activité dans le secteur résidentiel. Il mesure sa consommation pour le chauffage de son logement, l’eau chaude sanitaire, l’éclairage, les appareils divers, et bien sûr la consommation de son automobile.

C’est l’énergie qu’il achète directement en tant que telle, et qui atteint environ 800 TWh par an, soit 12,3 MWh par habitant.

C’est l’énergie « visible ».

Il reste donc 1 200 TWh d’énergie, qui est dépensée par les secteurs tertiaire et industriel pour créer le cadre de vie dans lequel les individus sont censés s’épanouir.

Cette énergie est parfois appelée « énergie grise » .

Lorsqu’une famille part en vacances en voiture, elle consomme une part d’énergie visible sous forme de carburant, mais aussi une part d’énergie grise qu’il a fallu dépenser pour fabriquer la voiture, construire les garages, construire l’autoroute, les aires de repos, les aires de service, les postes de péage, les bretelles de raccordement, les stations service, et mettre en place tous les services associés, y compris les services d‘urgences dans les CHU.

De même pour un voyage en train il a d’abord fallu construire un réseau, des machines, une signalisation, des gares, etc, etc…

Il est donc légitime, lorsqu’on analyse l’efficacité énergétique d’une action ou d’un appareil, de s’intéresser non seulement à l’énergie visible dépensée, mais aussi à l’énergie grise associée.

Globalement nous avons vu que pour 800 TWh d’énergie visible dépensée par les individus dans l’exercice de leur vie privée, il est dépensé 1 200 TWh d’énergie grise, soit un rendement énergétique de 40%.

Ce qui est logique puisque notre énergie est tirée essentiellement des combustibles fossiles par combustion, on ne peut donc échapper aux lois de la thermodynamique…

Si l’on connait la valeur globale de l’énergie grise, il est par contre très difficile de la chiffrer pour une application donnée.

On a des indications relativement précises pour les matériaux de base utilisés dans le bâtiment et dans l’industrie ( Aciers, cuivre, Aluminium, etc…), mais la précision diminue quand la complexité des produits finis croît.

Il est par exemple impossible de connaître l’énergie grise associée à la fabrication d’une voiture. Non pas qu’elle soit impossible à calculer, mais cette évaluation serait si complexe que le « jeu » n’en vaut pas la chandelle pour le constructeur, qui seul pourrait en connaître les éléments.

Par ailleurs, il ne faut pas oublier que derrière cette énergie grise il y a toute l’activité des secteurs tertiaire et industriel, qui génère les emplois des actifs, donc les salaires.

La chasse à l’énergie grise, le nouveau gibier à la mode, doit donc être pratiquée avec précautions, en sachant que derrière chaque MWh jugé dispendieux se cache peut-être notre propre emploi ou celui de notre enfant….

/image%2F0556431%2F20210601%2Fob_07a4c8_p1050018.JPG)